Artículo académico "Revisión sistemática de taxonomías de riesgos asociados a la Inteligencia Artificial"

Bas Graells, G., Tinoco Devia, R., Salinas Leyva, L. C., & Sevilla Molina, J. (2024). Revisión sistemática de taxonomías de riesgos asociados a la Inteligencia Artificial. Analecta Política, 14(26). https://doi.org/10.18566/apolit.v14n26.a08

El Observatorio de Riesgos Catastróficos Globales (ORCG) ha publicado Revisión sistemática de taxonomías de riesgos asociados a la Inteligencia Artificial en la revista Analecta Política, editada por la Universidad Pontificia Bolivariana de Colombia. El artículo ha sido incluido en una edición especial de la revista, dedicada a retos y soluciones efectivas para los problemas políticos globales.

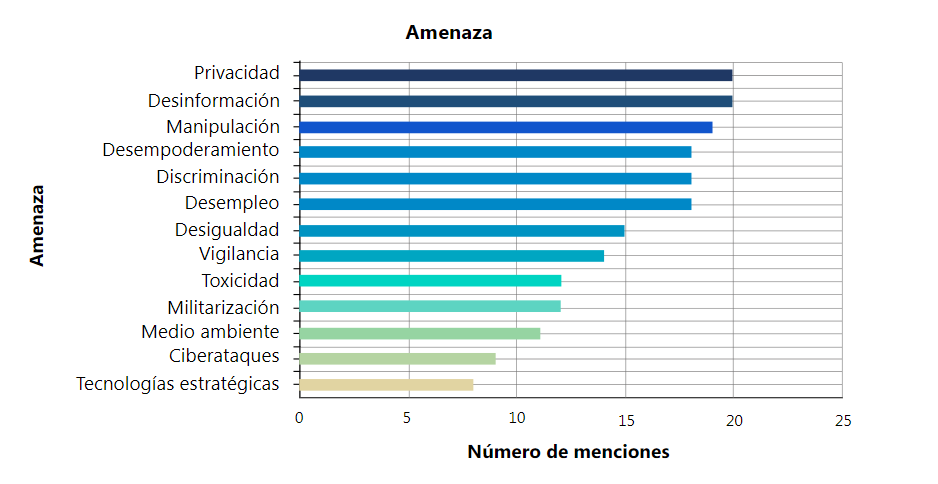

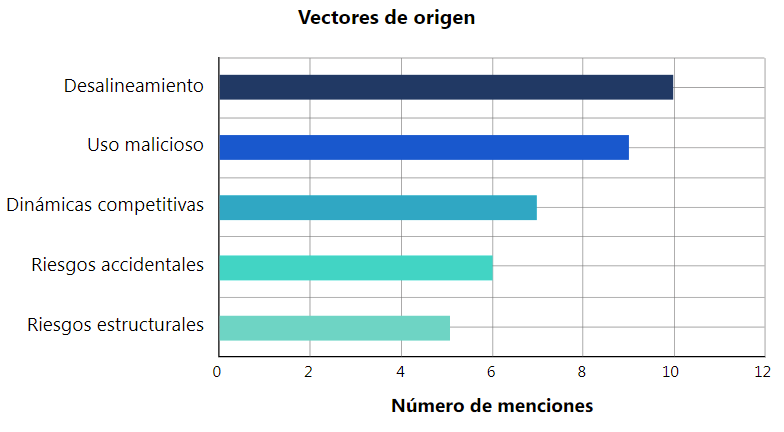

La pieza realiza una revisión sistemática de treinta y seis taxonomías de riesgos asociados a la Inteligencia Artificial (IA). Como resultado, los autores identifican principalmente 13 categorías de amenazas —privacidad, desinformación, manipulación, desempoderamiento, discriminación, desempleo, desigualdad, vigilancia, toxicidad, militarización, afectaciones medioambientales, ciberataques y desarrollo de tecnologías estratégicas—, así como 5 vectores de origen del riesgo especialmente salientes —desalineamiento, uso malicioso, dinámicas competitivas, accidentes y factores estructurales—. El artículo es el primer trabajo en español que realiza una categorización tan exhaustiva de los riesgos de la IA. Consideramos que este proyecto es un primer paso necesario para orientar evaluaciones de riesgo en más profundidad, identificando áreas que merecen mayor atención.

Figuras 1 y 2. Lista de amenazas y vectores de origen identificados por número de menciones

Además, la investigación permite extraer tres conclusiones sobre la literatura analizada. En primer lugar, se observa que la mayoría de los estudios se centran en amenazas más manifiestas, como la privacidad y la desinformación, posiblemente debido a su mayor plausibilidad. Por el contrario, amenazas como los ciberataques y el desarrollo de tecnologías estratégicas son menos citadas, a pesar de la creciente evidencia empírica y su potencial de escalar a escenarios más severos. En segundo lugar, encontramos que los artículos enfocados en el origen del riesgo tienden a considerar más frecuentemente riesgos extremos en comparación con los trabajos que abordan las consecuencias. Esto sugiere que la literatura ha sabido identificar las potenciales causas de una catástrofe, pero no las formas concretas en las que esta se puede materializar en la práctica. Finalmente, existe una cierta división entre aquellos artículos que tratan daños tangibles presentes y aquellos que cubren daños potenciales futuros. No obstante, varias amenazas se tratan en la mayoría de los artículos de todo el espectro, indicando que existen puntos de unión entre clústeres.

Puedes encontrar el artículo completo aquí. El Observatorio se compromete a continuar trabajando en mejorar la comprensión de los riesgos asociados a la inteligencia artificial para sumar conocimiento a la disciplina y capacitar a los tomadores de decisión en la gestión de los desafíos que plantea la tecnología.

Palabras clave:

Inteligencia artificial, Riesgo, Amenaza, Daño, Perjuicio, Taxonomía.