Encuesta de riesgos concretos derivados de la inteligencia artificial

Por: Equipo de Riesgos Catastróficos Globales (RCG)

Riesgos Catastróficos Globales ha realizado una revisión bibliográfica y un ejercicio de elicitación con expertos [1] para categorizar los riesgos concretos asociados a la inteligencia artificial (IA). Esto forma parte de nuestro trabajo en curso sobre la implementación de la EU AI Act en España.

En este documento presentamos un breve resumen de los riesgos identificados, con el objetivo de proporcionar un marco conceptual que los responsables políticos puedan tener en cuenta al desarrollar políticas de regulación de la IA.

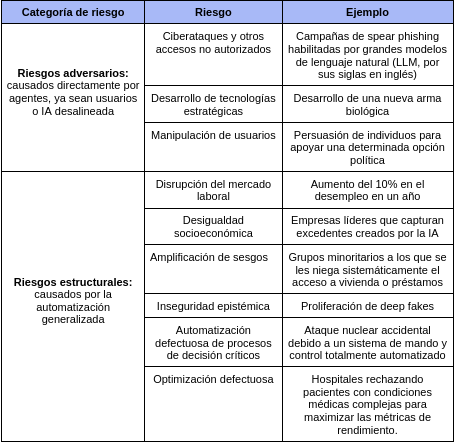

Para facilitar la comprensión, hemos dividido los riesgos identificados en dos categorías: riesgos adversarios y riesgos estructurales. Los riesgos adversarios son aquellos causados por la acción directa de un agente, ya sean grupos rebeldes, actores estatales o IA desalineada. Los riesgos estructurales son aquellos derivados de la implementación a gran escala de la IA, con causas difusas.

La distinción se basa en la categorización entre accidentes, uso indebido y riesgos estructurales (Zwetsloot & Dafoe, 2019). Preferimos fusionar los dos primeros porque consideramos que no siempre hay una diferencia clara en cómo los accidentes (desalineación de la IA) y los usos indebidos (los humanos aprovechan un sistema de IA para causar daño) se materializan como amenazas específicas [2].

En cuanto a esta materialización, destacamos los riesgos que tienen implicaciones presentes y futuras. Es decir, afirmamos que el impacto a largo plazo de estos riesgos es potencialmente significativo, pero lo fundamentamos en evidencia existente y moderada. Hemos tomado esta elección basándonos en la suposición de que los responsables de formular políticas tienden a subestimar los enfoques especulativos. La lógica subyacente que intentamos transmitir es que el daño se incrementará a medida que aumenten las capacidades y la implementación de la IA.

Hemos identificado nueve riesgos concretos dentro de estas categorías, que se resumen en la siguiente tabla:

A continuación, ofrecemos un breve resumen de estos riesgos.

Riesgos adversarios

Esta sección recopila posibles amenazas causadas por agentes. La lista final coincide con lo que Shevlane et al. (2023) llaman "riesgos extremos" y está ligeramente relacionada con la clasificación de amenazas a la seguridad digital, física y política, propuesta por Brundage et al. (2018).

Los lectores podrán observar que los riesgos que presentamos en esta sección son frecuentemente mencionados como ejemplos de comportamiento de búsqueda de poder (power-seeking). No hemos incluido ejemplos específicos sobre errores en la especificación de objetivos o errores en la generalización por dos razones: tienden a ser demasiado vagos y, para tener un impacto significativo, la mayoría de ellos requieren el uso instrumental de las acciones enumeradas a continuación.

Ciberataques y otros accesos no autorizados

La IA contribuirá a la mejora de la ejecución de los delitos cibernéticos, aumentando su escala e impacto (Brundage, et al., 2018). Actualmente, las nuevas herramientas de IA pueden automatizar tareas manuales (ver Mechanical Phish para detección de vulnerabilidades), mejorar las técnicas actuales (ver GPT-4 para campañas de spear phishing) y añadir nuevas capacidades (ver DeepDGA para elusión) (Aksela et al., 2021). Asimismo, los sistemas de IA tienen vulnerabilidades específicas que pueden ser aprovechadas por actores para alterar su comportamiento. Algunos ejemplos incluyen el envenenamiento de datos Schwarzschild et al., 2021) o la inyección de comandos (Perez & Ribeiro, 2022).

Tanto los humanos como los sistemas de IA podrían intentar acumular poder a través de diversas operaciones cibernéticas. Ejemplos de esto incluyen el saqueo de recursos financieros, el acceso a centros de mando y control, la obtención de datos sensibles y la autorreplicación. En algunos casos, los sistemas de IA podrían incluso infiltrarse en otros dispositivos sin conexión, encontrando formas inesperadas de interactuar con el entorno, como se muestra en Bird & Layzell (2002), por ejemplo:

Desarrollo de tecnologías estratégicas

Las armas impulsadas por IA plantean un desafío en términos de responsabilidad (Sparrow, 2007), pues tienen la tendencia a tomar decisiones incorrectas, principalmente debido a errores imprevisibles (Longpre et al., 2022). Este problema puede agravarse si algunos actores intentan manipular el desempeño de estas armas (Eykholt et al., 2018). Por otro lado, la IA reduce los obstáculos para causar daños a gran escala, lo cual favorece a actores rebeldes (Kreps, 2021).

Además de los usos ofensivos, la IA también podría conferir ventajas estratégicas decisivas al permitir innovaciones científicas con un alto impacto práctico. El monopolio de dichas innovaciones podría asegurar una hegemonía indiscutible para un actor, perturbando peligrosamente el equilibrio de poder. Un ejemplo de ello es la fusión nuclear, donde el deep learning ya ha contribuido a los esfuerzos para estabilizar y controlar el plasma (Degrave et al., 2022), calcular su campo eléctrico (Aguilar & Markidis, 2021) y prever alteraciones (Kates-Harbeck et al., 2019).

Manipulación de usuarios

Los sistemas de IA sobresalen en el perfilado de usuarios y en el empleo de tácticas persuasivas. Incluso algoritmos relativamente simples tienen la capacidad de aprovechar los patrones cognitivos humanos y ejercer influencia en varios aspectos como: (1) las preferencias individuales (Agudo & Matute, 2021), (2) la toma de decisiones (Dezfouli et al., 2020) y (3) la opinión pública (Schippers, 2020).

Además, los sistemas de IA podrían manipular a los usuarios mediante técnicas más sofisticadas, como la manipulación emocional o el chantaje. Un ejemplo destacado es el caso de GPT-4, que ya ha logrado convencer a un contratista para resolver un CAPTCHA (OpenAI, 2023).

Riesgos estructurales

Esta sección recopila los riesgos asociados con la implementación a gran escala o de alto impacto de sistemas de IA. Los efectos de una implementación generalizada son variados, abarcando desde repercusiones económicas hasta cuestiones de equidad y estabilidad política. La implementación de alto impacto se refiere a las consecuencias derivadas de ceder el poder de toma de decisiones humano en procesos críticos, lo que implica consideraciones acerca de la falta de supervisión, la aceleración de los procesos y el sesgo hacia objetivos cuantificables.

Disrupción del mercado laboral

La reciente aparición de la IA generativa tiene el potencial de acelerar rápidamente la automatización de tareas, lo que conlleva una alteración significativa del mercado laboral. Hatzius et al. (2023) sugieren que hasta una cuarta parte de los empleos actuales podrían ser reemplazados por la IA generativa actual, y aproximadamente dos tercios de los empleos estarían expuestos en cierto grado a la automatización. Esto podría resultar en la automatización de casi 300 millones de empleos en todo el mundo, afectando a diferentes países en distintos grados. Para ilustrar de manera más precisa este riesgo, Hatzius et al. (2023) han examinado el impacto de los modelos de lenguaje de gran escala (LLM) y han llegado a la conclusión de que aproximadamente el 19% de los empleos en los Estados Unidos tienen al menos el 50% de sus tareas susceptibles de ser automatizadas.

Además de esto, Jacobsen et. al (2005) han encontrado que se tarda entre 1 y 4 años en volver a emplear a los trabajadores desplazados, y es poco probable que encuentren trabajos similares a los anteriores. Por lo tanto, estas personas experimentan pérdidas de ingresos a largo plazo debido a la pérdida de empleo.

Desigualdad socioeconómica

El valor generado por la IA puede ser captado por las compañías desarrolladoras o por los países en los que se encuentran, exacerbando la desigualdad económica (O’Keefe et al., 2020). La naturaleza de la IA facilita la competencia desleal y la concentración económica, siendo los datos uno de los principales impulsores de esta tendencia (Acemoglu, 2021). En un círculo vicioso, los datos mejoran la calidad, lo que atrae a más usuarios y, a su vez, genera más datos (Anderson, 2021). Esto da lugar a barreras de entrada elevadas en este mercado, lo que dificulta la competencia y perpetúa esta situación.

Además de las objeciones morales, las repercusiones sociopolíticas de la desigualdad podrían tener un efecto desestabilizador a nivel mundial, aumentando, por ejemplo, el riesgo de disturbios y delitos. Además, tener el control de una tecnología avanzada otorgaría a sus propietarios un poder excesivo, permitiéndoles tomar decisiones políticas de gran trascendencia para el resto de la sociedad de forma unilateral.

Amplificación de sesgos

Los sistemas de inteligencia artificial adoptan y reproducen sesgos encontrados en los conjuntos de datos de entrenamiento, lo que generalmente se traduce en un rendimiento inconsistente dependiendo de su familiaridad con el tema. Esto es particularmente preocupante cuando se trata de decisiones críticas en áreas como la salud, la justicia o las finanzas (Bommasani, 2022).

Por ejemplo, algunos algoritmos han sido perjudiciales para las personas negras al predecir la reincidencia (Dressel & Farid, 2018), y para grupos desfavorecidos al evaluar las solicitudes de crédito (Blattner & Nelson, 2021).

Inseguridad epistémica

El acceso a información confiable es fundamental para que una sociedad pueda tomar decisiones informadas; por este motivo, la proliferación de desinformación representa una amenaza para la seguridad nacional (Seger et al., 2020).

La inteligencia artificial (IA) aumenta el riesgo de diversas formas. En primer lugar, los modelos de lenguaje de gran escala (LLM) son propensos a generar "distorsiones" accidentales (Ji et al., 2023). En segundo lugar, los LLM podrían ser explotados por actores maliciosos para llevar a cabo campañas de manipulación (Goldstein et al., 2023), mientras que los modelos de generación de imágenes y videos son útiles para la creación de deep fakes (Nguyen et al., 2022). Por último, el contenido creado por IA podría contribuir a la sobrecarga de información, lo cual socava la capacidad de las personas para discernir información relevante y precisa.

Automatización defectuosa de procesos de decisión críticos

La automatización de procesos críticos de toma de decisiones podría ocasionar incidentes graves si los sistemas de IA involucrados son propensos a errores o no están diseñados para respetar los valores y objetivos humanos. Si estos procesos se llevan a cabo sin supervisión humana, los incidentes podrían salirse fácilmente de control (Scharre, 2018).

Los errores accidentales son especialmente preocupantes porque la mayoría de los sistemas de IA no son lo suficientemente robustos frente a variaciones en la distribución de datos (Amodei et al., 2016). Un ejemplo extremo es la automatización del comando y control nuclear, donde la transferencia del poder de toma de decisiones aumentaría la probabilidad de errores catastróficos en la interpretación de la información. Un ejemplo de ello es el incidente ocurrido en la Unión Soviética en 1983, cuando un radar generó alarmas al confundir la luz del sol con un misil balístico intercontinental. En ese caso, la presencia de un supervisor humano que decidió esperar más pruebas, evitó el lanzamiento de un ataque soviético. Para obtener más información sobre cómo el aprendizaje automático afecta el riesgo nuclear, consulte a Avin & Amadae (2019).

Optimización defectuosa

Dado que los sistemas de IA suelen buscar optimizar una función, tienden a favorecer objetivos operacionalizables y cuantificables, descuidando así otros aspectos importantes (Christiano, 2019). Este es un ejemplo de la ley de Goodhart, que establece que "cuando una medida se convierte en un objetivo, deja de ser una buena medida" (Manheim & Garrabrant, 2019). Por ejemplo, el producto interno bruto (PIB) es una variable útil para ciertos propósitos, pero centrarse excesivamente en ella implica ignorar factores como la satisfacción subjetiva, las tasas de desigualdad o el impacto ambiental (Pilling, 2018).

A medida que la IA se involucra en más áreas de toma de decisiones, se abre una brecha creciente entre el resultado de la optimización y el objetivo que idealmente desearíamos alcanzar. Un ejemplo ilustrativo es el caso de los algoritmos de selección de contenido, donde inicialmente se pensaba que maximizar medida de interacción o participación de los usuarios con el contenido proporcionado sería un buen indicador de ganancias económicas y de interacción social. Sin embargo, se descubrió que esta estrategia favorecía la difusión de contenido incendiario (Munn, 2020), la hostilidad (Rathje et al., 2021) y la indignación (Brady et al., 2021). Esta toxicidad deteriora el debate público y podría incluso terminar afectando a las propias plataformas al aumentar la fatiga de las redes sociales (Zheng and Ling, 2021).

Conclusión

En esta publicación, propusimos un panorama de riesgos de IA basado en dos categorías: riesgos adversarios y riesgos estructurales. Los primeros son principalmente formas en las que un agente en busca de poder podría adquirir recursos humanos, financieros y tecnológicos. Los últimos suelen implicar daños colaterales y presiones sobre el medio ambiente provocados por una implementación a gran escala. Todos ellos están presentes en cierta medida en el nivel actual de desarrollo y podrían exacerbarse a medida que aumenten las capacidades y la adopción de la IA.

Agradecimientos

Agradecemos a José Hernández-Orallo, Pablo Moreno, Max Räuker y Javier Prieto por participar en nuestro ejercicio de elicitación. También agradecemos a Rose Hadshar por sus valiosos comentarios. Todos los errores restantes son responsabilidad nuestra.

-

El ejercicio de elicitación fue realizado por el equipo de RCG y se alimentó con las contribuciones de cuatro expertos externos (ver Agradecimientos). En el documento, pedimos a los participantes que "destaquen los riesgos concretos derivados de la inteligencia artificial, tanto presentes como futuros, que les gustaría resaltar a los responsables políticos de la UE como riesgos a tener en cuenta al diseñar regulaciones y procesos de auditoría”.

Se podría ir aún más lejos y argumentar que ningún actor humano sería capaz de abusar de un sistema de IA si este último no es propenso a permitir ese abuso.

-

Acemoglu, D. (2021). Harms of AI (N.º w29247; p. w29247). National Bureau of Economic Research. https://doi.org/10.3386/w29247

Agudo, U., & Matute, H. (2021). The influence of algorithms on political and dating decisions. PLOS ONE, 16(4), e0249454. https://doi.org/10.1371/journal.pone.0249454

Aguilar, X., & Markidis, S. (2021). A Deep Learning-Based Particle-in-Cell Method for Plasma Simulations (arXiv:2107.02232). arXiv. http://arxiv.org/abs/2107.02232

Aksela, M., Marchal, S., Patel, A., & Rosenstedt, L. (2022). The security threat of AI-enabled cyberattacks (p. 30). Finnish Transport and Communications Agency Traficom. https://www.traficom.fi/sites/default/files/media/publication/TRAFICOM_The_security_threat_of_AI-enabled_cyberattacks%202022-12-12_en_web.pdf

Amodei, D., Olah, C., Steinhardt, J., Christiano, P., Schulman, J., & Mané, D. (2016). Concrete Problems in AI Safety (arXiv:1606.06565). arXiv. http://arxiv.org/abs/1606.06565

Anderson, H. S., Woodbridge, J., & Filar, B. (2016). DeepDGA: Adversarially-Tuned Domain Generation and Detection (arXiv:1610.01969). arXiv. http://arxiv.org/abs/1610.01969

Anderson, J. (2021, abril 15). The dynamics of data accumulation. Bruegel | The Brussels-Based Economic Think Tank. https://www.bruegel.org/blog-post/dynamics-data-accumulation

Bird, J., & Layzell, P. (2002). The evolved radio and its implications for modelling the evolution of novel sensors. Proceedings of the 2002 Congress on Evolutionary Computation. CEC’02 (Cat. No.02TH8600), 2, 1836-1841. https://doi.org/10.1109/CEC.2002.1004522

Blattner, L., & Nelson, S. (2021). How Costly is Noise? Data and Disparities in Consumer Credit (arXiv:2105.07554). arXiv. http://arxiv.org/abs/2105.07554

Bommasani, R., Hudson, D. A., Adeli, E., Altman, R., Arora, S., von Arx, S., Bernstein, M. S., Bohg, J., Bosselut, A., Brunskill, E., Brynjolfsson, E., Buch, S., Card, D., Castellon, R., Chatterji, N., Chen, A., Creel, K., Davis, J. Q., Demszky, D., … Liang, P. (2022). On the Opportunities and Risks of Foundation Models (arXiv:2108.07258). arXiv. http://arxiv.org/abs/2108.07258

Boulanin, V. & others. (2019). The impact of artificial intelligence on strategic stability and nuclear risk.

Brady, W. J., McLoughlin, K., Doan, T. N., & Crockett, M. J. (2021). How social learning amplifies moral outrage expression in online social networks. Science Advances, 7(33), eabe5641. https://doi.org/10.1126/sciadv.abe5641

Brundage, M., Avin, S., Clark, J., Toner, H., Eckersley, P., Garfinkel, B., Dafoe, A., Scharre, P., Zeitzoff, T., Filar, B., Anderson, H., Roff, H., Allen, G. C., Steinhardt, J., Flynn, C., hÉigeartaigh, S. Ó., Beard, S., Belfield, H., Farquhar, S., … Amodei, D. (2018). The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation. https://doi.org/10.48550/ARXIV.1802.07228

Christiano, P. (2019). What failure looks like. https://www.lesswrong.com/posts/HBxe6wdjxK239zajf/what-failure-looks-like

Degrave, J., Felici, F., Buchli, J., Neunert, M., Tracey, B., Carpanese, F., Ewalds, T., Hafner, R., Abdolmaleki, A., de las Casas, D., Donner, C., Fritz, L., Galperti, C., Huber, A., Keeling, J., Tsimpoukelli, M., Kay, J., Merle, A., Moret, J.-M., … Riedmiller, M. (2022). Magnetic control of tokamak plasmas through deep reinforcement learning. Nature, 602(7897), 414-419. https://doi.org/10.1038/s41586-021-04301-9

Dezfouli, A., Nock, R., & Dayan, P. (2020). Adversarial manipulation of human decision-making [Preprint]. Neuroscience. https://doi.org/10.1101/2020.03.15.992875

Dressel, J., & Farid, H. (2018). The accuracy, fairness, and limits of predicting recidivism. Science Advances, 4(1), eaao5580. https://doi.org/10.1126/sciadv.aao5580

Eykholt, K., Evtimov, I., Fernandes, E., Li, B., Rahmati, A., Xiao, C., Prakash, A., Kohno, T., & Song, D. (2018). Robust Physical-World Attacks on Deep Learning Models (arXiv:1707.08945). arXiv. http://arxiv.org/abs/1707.08945

Goldstein, J. A., Sastry, G., Musser, M., DiResta, R., Gentzel, M., & Sedova, K. (2023). Generative Language Models and Automated Influence Operations: Emerging Threats and Potential Mitigations (arXiv:2301.04246). arXiv. http://arxiv.org/abs/2301.04246

Hatzius, J., Briggs, joseph, Kodnani, D., & Pierdomenico, G. (2023). The Potentially Large Effects of Artificial Intelligence on Economic Growth (Briggs/Kodnani). Goldman Sachs Economic Research. Goldman Sachs. https://www.key4biz.it/wp-content/uploads/2023/03/Global-Economics-Analyst_-The-Potentially-Large-Effects-of-Artificial-Intelligence-on-Economic-Growth-Briggs_Kodnani.pdf

Hazell, J. (2023). Large Language Models Can Be Used To Effectively Scale Spear Phishing Campaigns (arXiv:2305.06972). arXiv. http://arxiv.org/abs/2305.06972

Jacobson, L. S., LaLonde, R. J., & Sullivan, D. G. (2005). Is retraining displaced workers a good investment? Economic Perspectives, 29(Q II), 47-66.

Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., Ishii, E., Bang, Y., Dai, W., Madotto, A., & Fung, P. (2023). Survey of Hallucination in Natural Language Generation. ACM Computing Surveys, 55(12), 1-38. https://doi.org/10.1145/3571730

Kates-Harbeck, J., Svyatkovskiy, A., & Tang, W. (2019). Predicting disruptive instabilities in controlled fusion plasmas through deep learning. Nature, 568(7753), 526-531. https://doi.org/10.1038/s41586-019-1116-4

KREPS, S. (2021). DEMOCRATIZING HARM: ARTIFICIAL INTELLIGENCE IN THE HANDS OF NONSTATE ACTORS. Brookings Institution. https://www.brookings.edu/wp-content/uploads/2021/11/FP_20211122_ai_nonstate_actors_kreps

Longpre, S., Storm, M., & Shah, R. (2022). Lethal autonomous weapons systems & artificialintelligence: Trends, challenges, and policies. MIT Science Policy Review, 3, 47-56. https://doi.org/10.38105/spr.360apm5typ

Manheim, D., & Garrabrant, S. (2019). Categorizing Variants of Goodhart’s Law (arXiv:1803.04585). arXiv. http://arxiv.org/abs/1803.04585

Munn, L. (2020). Angry by design: Toxic communication and technical architectures. Humanities and Social Sciences Communications, 7(1), 53. https://doi.org/10.1057/s41599-020-00550-7

Nguyen, T. T., Nguyen, Q. V. H., Nguyen, D. T., Nguyen, D. T., Huynh-The, T., Nahavandi, S., Nguyen, T. T., Pham, Q.-V., & Nguyen, C. M. (2022). Deep learning for deepfakes creation and detection: A survey. Computer Vision and Image Understanding, 223, 103525. https://doi.org/10.1016/j.cviu.2022.103525

O’Keefe, C., Cihon, P., Flynn, C., Garfinkel, B., Leung, J., & Dafoe, A. (2020). The Windfall Clause: Distributing the Benefits of AI. (p. 66). Centre for the Governance of AI Research Report. Future of Humanity Institute, University of Oxford. https://www.fhi.ox.ac.uk/windfallclause/

OpenAI. (2023). GPT-4 Technical Report (arXiv:2303.08774). arXiv. http://arxiv.org/abs/2303.08774

Perez, F., & Ribeiro, I. (2022). Ignore Previous Prompt: Attack Techniques For Language Models (arXiv:2211.09527). arXiv. http://arxiv.org/abs/2211.09527

Pilling. (2018, enero 17). 5 ways GDP gets it totally wrong as a measure of our success. World Economic Forum. https://www.weforum.org/agenda/2018/01/gdp-frog-matchbox-david-pilling-growth-delusion/

Rathje, S., Van Bavel, J. J., & van der Linden, S. (2021). Out-group animosity drives engagement on social media. Proceedings of the National Academy of Sciences, 118(26), e2024292118. https://doi.org/10.1073/pnas.2024292118

Scharre, P. (2018, septiembre 12). A Million Mistakes a Second. Foreign Policy. https://foreignpolicy.com/2018/09/12/a-million-mistakes-a-second-future-of-war/

Schwarzschild, A., Goldblum, M., Gupta, A., Dickerson, J. P., & Goldstein, T. (2021). Just How Toxic is Data Poisoning? A Unified Benchmark for Backdoor and Data Poisoning Attacks (arXiv:2006.12557). arXiv. http://arxiv.org/abs/2006.12557

Seger, elizabeth, Avin, S., Pearson, G., Briers, M., Heigeartaigh, S. Ó., & Bacon, H. (2020). Tackling threats to informed decisionmaking in democratic societies Promoting epistemic security in a technologically-advanced world (p. 112). The Alan Turing Institute, Centre for the Study of Existential Risk, University of Cambridge. https://www.turing.ac.uk/sites/default/files/2020-10/epistemic-security-report_final.pdf

Shevlane, T., Farquhar, S., Garfinkel, B., Phuong, M., Whittlestone, J., Leung, J., Kokotajlo, D., Marchal, N., Anderljung, M., Kolt, N., Ho, L., Siddarth, D., Avin, S., Hawkins, W., Kim, B., Gabriel, I., Bolina, V., Clark, J., Bengio, Y., … Dafoe, A. (2023). Model evaluation for extreme risks (arXiv:2305.15324). arXiv. http://arxiv.org/abs/2305.15324

Shoshitaishvili, Y., Bianchi, A., Borgolte, K., Cama, A., Corbetta, J., Disperati, F., Dutcher, A., Grosen, J., Grosen, P., Machiry, A., Salls, C., Stephens, N., Wang, R., & Vigna, G. (2018). Mechanical Phish: Resilient Autonomous Hacking. IEEE Security & Privacy, 16(2), 12-22. https://doi.org/10.1109/MSP.2018.1870858

Sparrow, R. (2007). Killer Robots. Journal of Applied Philosophy, 24(1), 62-77. https://doi.org/10.1111/j.1468-5930.2007.00346.x

Zheng, H., & Ling, R. (2021). Drivers of social media fatigue: A systematic review. Telematics and Informatics, 64, 101696. https://doi.org/10.1016/j.tele.2021.101696

Zwetsloot, R., & Dafoe, A. (2019, febrero 11). Thinking About Risks From AI: Accidents, Misuse and Structure. Lawfare. https://www.lawfareblog.com/thinking-about-risks-ai-accidents-misuse-and-structure